围绕着关系型数据库唯一索引相关的问题,还是不少的,可参考历史文章,

《》

《》

《》

《》

碰巧看到GreatSQL社群推送的这篇文章《》,给我们介绍了MySQL数据库中唯一索引和重复值相关的一个场景mysql去重,值得学习借鉴。

一、问题

MySQL5.7.38主从架构,主节点唯一索引上(唯一索引不是主键)有重复值,全部从节点报1062,SQL线程状态异常,根据SQL线程报的binlog位置点,insert数据时有重复值,插入失败

二、原因

unique_checks=0时导致,在bug(106121)列表中官方解释的原因:该参数关闭,维护唯一索引时,不会进行物理读,只会进行内存读,来确保唯一索引的唯一性,即如果内存中有冲突数据就报1062mysql去重,如果内存中没有冲突数据插入成功,不会进行IO来将唯一索引相关的数据页拉取到内存。

官方的回复”IMHO this is not a bug”,我理解的意思”不要你觉得,我要我觉得,我就是这么玩的”。

三、故障解决方案

(1)临时解决方案

恢复主从:

缺点是:不能够解决数据重复的问题,切换主从后会面临更多重复数据的问题,如果从节点接收查请求且使用到了原唯一索引的字段,那sql效率会严重下降,但是可以解决主从复制停止的问题

(2)永久解决方案

业务自己去重,不要插入重复数据。

参数unique_checks保持为1。

关于重复的业务数据:与业务交流,确定重复数据的处理方式。

四、复现步骤

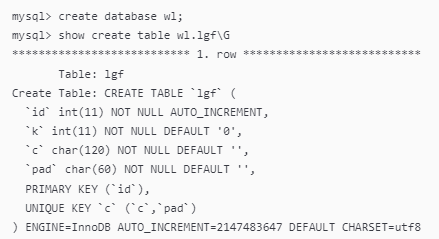

1. 表结构,

Python生成随机数据,插入表,并另起会话观察总数据量约10w条左右(保证聚簇索引中的前边的数据与后边的数据所在的叶子节点的页相差很远),

2. 查询数据,

3. 拼接SQL

c与pad的值与id=1360值相等,id=1000000000(表中无该id行),

4. 重启mysqld

目的是清除缓存,为了清空MySQL缓存,还可结合以下几个参数修改my.cnf文件,重启MySQL实例

5. 重新插入重复唯一索引数据,

mysql> set unique_checks=0;

mysql> use wl

mysql> insert into wl.lgf(id,c,pad) values(10000000,'3344825394389018','7962994492618902') ;

Query OK, 1 row affected (0.00 sec)

6. 查询:force index指定主键查询数据,

mysql> select * from wl.lgf force index(primary) where c='3344825394389018' and pad='7962994492618902';

+----------+--------+------------------+------------------+

| id | k | c | pad |

+----------+--------+------------------+------------------+

| 1360 | 403078 | 3344825394389018 | 7962994492618902 |

| 10000000 | 0 | 3344825394389018 | 7962994492618902 |

+----------+--------+------------------+------------------+

2 rows in set (0.37 sec)

参考文档,

如果您认为这篇文章有些帮助,还请不吝点下文章末尾的”点赞”和”在看”,或者直接转发pyq,

近期更新的文章:

《》

《》

《》

《》

《》

近期的热文:

《》

《》

文章分类和索引:

》

限时特惠:本站每日持续更新海量展厅资源,一年会员只需29.9元,全站资源免费下载

站长微信:zhanting688